|

| Центральный процессор — это вычислительное устройство, используемое в настольных ПК и портативных компьютерах. (Источник изображения: Intel) |

По мере того, как приложения машинного обучения продолжают развиваться, требования к вычислительной обработке возрастают соответственно. Нейронная сеть сегодня лежит в основе машинного обучения. Эта сеть основана на искусственном нейроне, который математически является нелинейной функцией, состоящей из входов взвешенных сумм. Коллекция этих искусственных нейронов, сформированная в слои, создает хранилище данных вычислительных сетей. Поскольку машинное обучение применяется к приложениям с интенсивным использованием данных, таким как поиск в Интернете, обработка естественного языка (NLP) и распознавание образов, закон Мура менее актуален. Центральный процессор (CPU), обеспечивающий вычислительный процесс для современных вычислительных машин, не может удовлетворить требованиям «n-многомерных» наборов данных.

Если Вам нужен дата-центр для серверов и телеком. оборудования (в том числе и для создания нейронной вычислительной сети), лучше всего разместить их в дата-центре компании MixTelecom — https://www.mixtelecom.ru/razmeshchenie-oborudovaniya.html — дата-центром пользуются такие ведущие компании, как Мегафон, Билайн, Эр.телеком, СОГАЗ и т.д.

Процессор / микропроцессор

Центральный процессор (CPU) или микропроцессор представляет собой сложную электронную схему, состоящую из миллионов транзисторов. Электронная схема — вычислительный мозг компьютера, способного выполнять команды программы, выполняющей основные вычислительные задачи. Эти вычислительные задачи состоят из операций арифметического логического, управления и ввода / вывода (ввода-вывода). Приложения машинного обучения, такие как линейная регрессия и сверточные нейронные сети (CNN), могут выполняться на процессоре. Операции последовательной и линейной обработки ограничены обработкой процессором n-многомерных наборов данных.

|

| Изображены электронные подсхемы типичной архитектуры процессора или микропроцессора. (Источник изображения: Heath Electronics) |

ГПУ

Графический процессор (GPU) является следующим вычислительным эволюционным шагом в обработке возможностей. В отличие от процессора или микропроцессора, GPU предназначен для быстрого изменения и управления памятью для ускорения изображений. Системы видеоигр, такие как Playstation от Sony и Nintendo, используют графические процессоры для управления изображениями, отображаемыми на мониторе мультимедийного интерфейса высокой четкости (HDMI). Для создания 3D-изображений на графическом процессоре используется сопоставление текстур, что требует высокой плотности компьютера и глубоких конвейеров или сотен многоядерных ресурсов сцены на графических устройствах. Графические процессоры могут одновременно выполнять матричные операции по сравнению с процессором. Следовательно, графический процессор является устройством параллельной обработки. Хотя вычислительные возможности графического процессора быстрее, чем у процессора из-за функции параллельной обработки, GPU не может выполнять n-многомерные вычисления.

|

| На фото представлен графический процессор NVIDIA K80. (Изображение любезно предоставлено: Nvidia) |

ТПУ

Внедрение тензорной процессорной единицы (TPU) произошло на конференции Google Mountain View, California I / O в 2016 году. Google начала разработку TPU в 2013 году. TPU — это аппаратное решение на заказ для поддержки новой машины изучение исследований. Это специализированная интегральная схема (ASIC), которая имеет потенциал сделать больше в n-многомерной математике.

n-многомерный массив, известный как Tensor, лежит в основе алгоритмов машинного обучения. Тензором может быть один вход (скаляр), вектор (несколько входов) или матрица входов. Google TensorFlow — это рабочий процесс, который позволяет обучать, тестировать и производить развертывание приложений машинного обучения. С помощью TensorFlow TPU можно управлять, чтобы обеспечить порядок производительности на ватт для машинного обучения с использованием лучших методов оптимизации. Эти методы оптимизации основаны на математике исчисления.

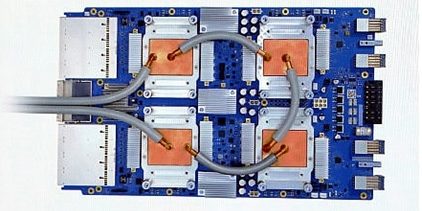

|

| TPU компании Google — это аппаратная микросхема ASIC, разработанная специально для приложений ML, основанных на тензоре. (Источник изображения: Google) |

ТПУ были развернуты в центрах обработки данных Google с 2015 года. Центры данных на базе ТПУ ускоряют предоставление линейной алгебры, поддерживаемое ТПУ, с умножением на 65 536 8-разрядных умножителей (МАС) который обеспечивает высокую вычислительную пропускную способность. В отличие от графического процессора и процессора, потребляемая мощность ниже в TPU, потому что приложение машинного обучения подключается только к программному алгоритму устройства при выполнении тензорных операций.

. Для получения дополнительной технической информации о ТПУ инструктор по искусственному интеллекту / машинисту Сирадж Равал выпустил видеоролик YouTube . В видеоролике Raval предоставляет код TPU, разработанный в Colaboratory для сравнения производительности процессора с частотой TPU при вычислении простой проблемы с добавлением. Кроме того, технический документ, опубликованный компанией Google по анализу производительности центров обработки данных в ТПУ, можно получить на веб-сайте arvix.org .

Дон Уилчер — страстный преподаватель электроники и инженер-электрик с 26-летним опытом работы в промышленности. Он работал над системами промышленной робототехники, автомобильными электронными модулями и системами и встроенным беспроводным управлением для небольших бытовых приборов.

ССЫЛКИ ПО ТЕМЕ:

- NXP хочет довести машинное обучение до граничных процессоров

- 10 компаний искусственного интеллекта, которые вы должны знать

- Исследование говорит, что AI может доставить огромную финансовую ценность промышленности

|

|