|

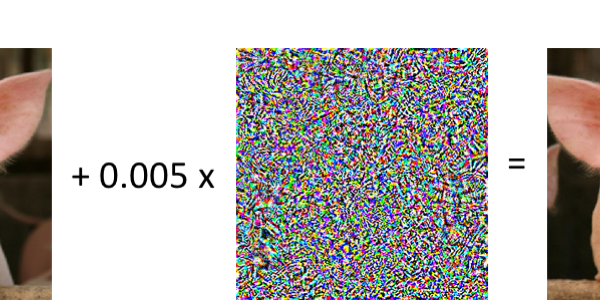

| Введя незаметные примеры состязаний в изображение свиньи, исследователи смогли обмануть систему распознавания образов, полагая, что она смотрит на авиалайнер. (Источник изображения: MIT CSAIL) |

В 1985 году знаменитый невролог Оливер Сэкс выпустил свою книгу, Человек, который искупил свою жену за шляпу. Титулярное исследование случая включало человека с визуальной агнозией, неврологическим состоянием, которое делает пациентов неспособными распознавать объекты или, в этом случае, создает дикие диссоциации в объектах (т. Е. При принятии головы вашей жены на шляпу). Это трагическое состояние, но также и то, что предлагает невропатам глубокое понимание того, как работает человеческий мозг. Изучая области мозга, которые повреждены в случае визуальной агностики, исследователи могут определить, какие структуры играют роль в распознавании объектов.

Хотя искусственный интеллект не достиг уровня сложности человеческого мозга, можно подойти к исследованию ИИ таким же образом. Вы когда-нибудь ошибались бы за свинью для авиалайнера? Как насчет изображения городского пейзажа для миньона из «Презренного Меня?» Вы когда-нибудь видели, как кто-то стоял и думал, что они лежат? Скорее всего, вы этого не сделали. Но алгоритмы машинного обучения могут совершать такие ошибки, когда человек никогда этого не сделает.

Предоставление системному «повреждению головного мозга» — понимание ошибок в системе — позволяет исследователям разрабатывать более надежные и точные системы. Такова роль так называемых состязательных примеров — по существу, оптических иллюзий для ИИ.

Множество людей были обмануты оптическими иллюзиями или сложными магическими трюками, но мы рассказываем о нашей повседневной жизни, которая точно распознает объекты и звуки. Но та же самая задача распознавания образа, которая может казаться более чем очевидной для человека, может фактически обмануть ИИ из-за крошечных аномалий или возмущений в изображении. Смежные примеры незаметны для людей, но они могут заставить ИИ делать ошибки и просчеты, которые никогда не было бы здоровым человеком. Таким образом, изображение городской улицы, которая выглядит нормально для человека, может содержать скрытые возмущения, которые заставляют систему ИИ думать, что она смотрит на миньонов. (Исследователи ИМ Facebook продемонстрировали этот точный случай в исследовании 2017 года.)

Создание состязательных примеров является важной частью обеспечения того, чтобы алгоритмы и нейронные сети были такими же надежными, как их биологические аналоги, особенно когда они были развернуты в реальном мире. В конце концов, мы хотим, чтобы объект был распознан как то, что он не имеет значения, какой размер, ориентация или цвет, или количество помех или помех, наложенных на него.

ССЫЛКИ ПО ТЕМЕ

-

10 компаний искусственного интеллекта, которые вы должны знать

-

Кто боится генерала А.И.

-

Кибербезопасность — это не работа для людей

И мы не хотим, чтобы эти системы были намеренно и легко обмануты. Идея быть в состоянии незаметно обмануть ИИ, конечно, имеет более широкие последствия для общей верности и уровня производительности ИИ. Это также вызывает более глубокие проблемы безопасности.

В исследовании 2018 года, опубликованном в журнале Computer Vision и распознавании образов исследователи смогли заставить нейронную сеть ошибочно классифицировать дорожные знаки с использованием состязательных примеров. Еще одно исследование в 2018 году, проведенное исследователями из Калифорнийского университета в Беркли, показало, что состязательные примеры скрытые в аудиозаписях могут обмануть систему распознавания речи в транскрибирование того, что звучит как нормальное сообщение любому человеку, в совершенно другое сообщение выбора злоумышленника. Представьте себе, что хакер может отправлять аудиозапись Alexa или аналогичную программу, которая может звучать как простой запрос о погоде дня, но на самом деле содержит скрытый вредоносный код и инструкции.

Экстраполируя случаи, подобные этим, указывает на ряд потенциальных опасностей в реальном мире. Вредоносные злоумышленники могут использовать состязательные примеры для передачи явных изображений через фильтры, доставки вирусов и вредоносного ПО в системы, прокрадывания мимо камер наблюдения и даже трюков автономных и полуавтономных транспортных средств для игнорирования сигналов дорожного движения, знаков и маркеров полосы.

Хотя таких атак еще не было в реальном мире, они представляют собой очень реальную и неизбежную угрозу, если исследователи и разработчики не смогут опередить ее.

|

| Facebook Исследователи ИИ использовали новый метод разработки состязательных примеров, чтобы обмануть ИИ, глядя на улицу города, думая, что он смотрит на миньона. (Источник изображения: Facebook AI Research) |

Простой трюк

Задача исследователей ИИ сегодня заключается в том, что современные методы создания состязательных примеров, хотя и эффективны, не обязательно дают качество и точность результатов, которые желают исследователи и разработчики, особенно когда они применяются к приложениям за пределами распознавания образов, например как распознавание речи, оценка человеческой позы (распознавание людей в заданном пространстве) и машинный перевод (перевод языка с одной машины на другую).

Типичный состязательный пример создается путем введения какого-либо нарушения в набор данных. В случае изображения он может изменять значения или вес пикселей в изображении. В случае речи это может добавить незаметный фоновый шум или искажение слов. Все это проблемы, которые люди могут преодолеть с легкостью, но они могут быть проблематичными для ИИ.

Проблема с этими методами заключается в том, что полученные ими результаты не обязательно переводят в непосредственные средства улучшения нейронной сети или системы. Например, качество систем распознавания речи измеряется по частоте ошибок их слов. Итак, если можно обмануть систему в ошибке слова «яблоко» для «оранжевого», вопрос для исследователей: что такое решение? Должна ли система больше обучаться распознаванию этих конкретных слов? Следует ли лучше понять общий контекст предложения, чтобы лучше понять, что это за слово? Может быть, еще одно решение?

Добавлен к этому, что методы создания состязательных примеров не переносятся между моделями. Учитывая многоуровневую природу нейронных сетей, причем разные уровни выполняют свои собственные конкретные задачи, это означает, что исследователям необходимо создать другой пример состязательности для атаки на определенные модели. Это может быть трудоемким и сложным.

Однако исследовательские группы работают над решением этой проблемы. В 2017 году исследователи из Facebook AI Research (FAIR) в Париже и Университет Бар-Илан в Израиле опубликовали исследование о новой гибкой модели для тестирования нейронных сетей для потенциально опасных ошибок классификации, получивших название Гудини.

| В этом видео исследователи демонстрируют обман AI, думая, что живая черепаха на самом деле является винтовкой. (Источник: Международная конференция по машиностроению 2018 года) |

Целью Houdini является переход к методу одного размера — все, что может создать мощные примеры состязательности для моделей и приложений. Чем проще для исследователей создавать мощные и точные примеры состязательности, тем лучше они могут работать для улучшения ИИ.

Верный своему однофамильцу, Гудини обманывает ИИ в том, что он видит и слышит, что он не должен все с возмущениями, даже менее ощутимыми, чем те, которые созданы старыми методами. Гудини атакует ИИ с уровнем сложности, который позволяет применять состязательные примеры в приложениях, помимо распознавания изображений, в целом, предоставляя исследователям более глубокое понимание того, как функционируют нейронные сети и алгоритмы, и как и почему они делают ошибки.

Закрытие этого разрыва между нашими ожиданиями и алгоритмами алгоритмов AI — важный шаг, особенно для продвижения ИИ в сторону все более сложных приложений, таких как автономные транспортные средства и автоматизация производства на высоком уровне. Вредоносный взлом в сторону, даже непредвиденные ошибки и иллюзии ИИ могут привести к потерям времени и денег на заводском этаже. Как однажды сказал сам Гарри Гудини: «Что видят глаза, а уши слышат, ум верит».

Крис Вильц — старший редактор в Design News охватывающий новые технологии, включая AI, VR / AR и робототехнику.