Периодически проверять состояние сайта нужно даже опытным веб-мастерам. Проблемы с индексацией, юзабилити, технические ошибки будут влиять на трафик и конверсии, а значит и на доход. Ошибки могут появляться после апдейтов, из-за невнимательности, по другим причинам — в любом случае каждый владелец сайта или специалист следит за состоянием ресурса и периодически проводит аудит. Этим мы сейчас и займемся — расскажем, как проверить сайт по основным параметрам самостоятельно, не обращаясь к дорогим студиям и экспертам.

Этот чек-лист универсален, корректируйте пункты под свой ресурс — возможно, некоторые будут неактуальны из-за размера сайта или специфики. Советуем расставлять приоритеты и начинать с самых важных конверсионных страниц, которые влияют на эффективность бизнеса.

Содержание статьи

Индексирование страниц

Проверьте индексацию страниц: введите site:адрес сайта в поисковиках и посмотрите, сколько страниц нашла ПС, выводится ли главная страница на первом месте. Перед любой проверкой через ПС лучше чистить кэш и смотреть в режиме Инкогнито, чтобы персонализированная выдача не влияла на результаты.

У Яндекса и Google есть кабинеты для веб-мастеров, в которых можно посмотреть, как бот обходит сайт.

Проверьте индексирование в Яндексе

В Яндекс.Вебмастере посмотрите Индексирование — Статистика обхода, там вы увидите список страниц, которые обошел робот.

В отчете Индексирование — Страницы в поиске — Страницы в поиске — Все страницы есть список всех страниц, участвующих в поиске Яндекса.

В разделе Индексирование — Страницы в поиске — Страницы в поиске — Исключенные страницы увидите те, которые Яндекс не включил в поиск. Объяснения к причинам перечислены в этом разделе помощи Яндекса. Если среди исключенных страниц есть важные, найдите причину и запишите себе задание для исправления ошибки, чтобы вернуть страницу в индекс.

Если вам неудобно смотреть в интерфейсе, сделайте выгрузку в Excel.

Вы увидите такие параметры:

- url — адрес страницы,

- prevHttpCode — статус страницы в предыдущий обход,

- currentHttpCode — статус страницы в последний обход,

- lastAccess — дата последнего захода на страницу.

Обратите внимание на параметры prevHttpCode и currentHttpCode страницы:

- Если она была 200 ОК, а стала 404, посмотрите, почему она стала недоступна и нужно ли ее вернуть.

- Если наоборот страница выдавала ошибку, а стала 200 ОК, посмотрите, почему ошибка воспринимается роботом как нормальная страница.

- Если сервер отдает код ответа 502 или 500, проверьте стабильность его работы.

- Если появились новые страницы с кодом ответа 200, возможно, в индекс попали мусорные или служебные страницы, которые не предназначены для вывода в ПС.

Проверьте индексирование в Google

В консоли Google посмотрите отчет Индекс Google — Заблокированные ресурсы — %хост%. там будет список заблокированных для бота ресурсов и страниц. Если заблокированы важные страницы, они могут не попасть в индекс.

Исключенные страницы есть в разделе Статус индексирования — Индексирование отправленных URL — Исключено. Пояснения по ошибкам и причинам исключения есть в разделе помощи Google.

Также можно сделать выгрузку в Excel. Анализ похож на тот, что был описан для Яндекса: нужно найти проблемы и составить задачи для решения, чтобы вернуть важные страницы в индекс.

Доступность и санкции

Проверьте, доступен ли сайт для ПС, и нет ли санкций.

Проверьте доступность для ПС

Файл robots.txt содержит указания для поисковых роботов о том, какие страницы можно индексировать,а какие не нужно.

Проверьте наличие, корректность и содержание файла robots.txt. Файл должен:

- находиться в корневом каталоге;

- отдавать код ответа 200 ОК;

- иметь расширение .txt;

- называться строчными буквами;

- весить не больше 32 КБ;

- содержать только латиницу;

- содержать каждый префикс URL на отдельной строке.

Посмотрите, какой контент заблокирован для поисковых ботов, какой открыт для индексации. Яндекс обычно следует указаниям в robots.txt, а для Google они служат рекомендацией, а не правилом.

Выключите JavaScript, куки и CSS. Используйте WebDeveloperToolbar и посмотрите, что стало с контентом на сайте: остался ли он на месте, как работает навигация.

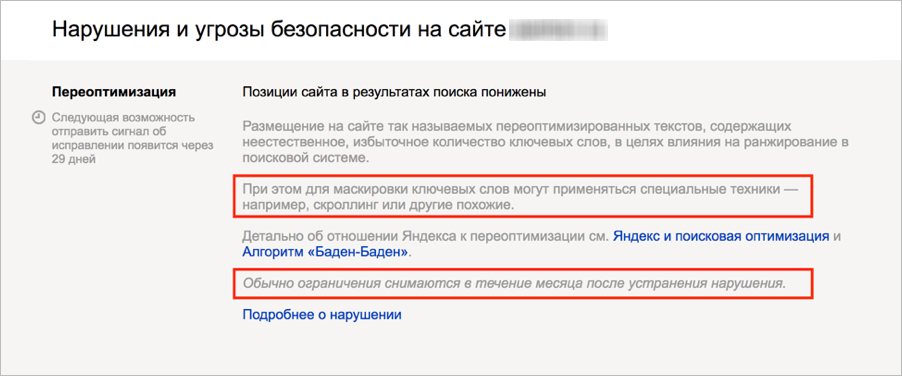

Проверьте наличие санкций

За нарушения продвижения сайта поисковые системы могут наложить санкции, о них обычно предупреждают в письме или уведомлением в консоли. Проверьте уведомления Вебмастера и Поисковой консоли, может, вы пропустили предупреждение. Если оно есть, исправьте ошибки и уведомите об этом ПС.

Пример оповещения о хостовых санкциях

Дублированный контент

Дублированный контент влечет проблемы в SEO — к примеру, вероятность санкций за неуникальность, признание первоисточником более трастового сайта, выпадение из индекса, потому что поисковик не будет ранжировать две одинаковых страницы.

Что искать:

- Дубли вашего контента на чужих сайтах.

Google может посчитать важным контент на чужом более авторитетном сайте, даже если он не первоисточник. Обратитесь с к хостеру, к самому копипастеру с просьбой удалить или поставить ссылку на ваш сайт, или даже обратитесь в суд, если конкурент использовал ваш контент в коммерческих целях. - Повторяющийся контент на страницах своего сайта.

Это может влиять на видимость этих страниц в выдаче. Тогда замените текст на уникальный или удалите дублирующие страницы.

Если вы сделали поддомены для регионального продвижения в Яндекс, то проверьте, есть ли дубли контента. Для каждого поддомена контент должен быть адаптирован под регион, иначе они не имеют смысла.

Региональность

Если работа вашего сайта связана с регионами, пункт имеет смысл. Пропустите, если вы владелец общетематических сайтов, порталов, блогов, некоммерческих сайтов и других проектов без региональности.

Для региональности есть возможность настроить поддомены или подпапки.

Для Яндекса часто выбирают поддомены. Если на вашем сайте сделаны поддомены, проверьте, какая региональность указана в Яндекс.Вебмастере для основного сайта и поддоменов — региональные офисы нужно привязывать к поддоменам, а к основному домену не нужно. Иногда привязка к основному домену появляется сама, поэтому проверьте это в Вебмастере и отвяжите, если нужно.

Если вы решили создавать подпапки для регионального ранжирования в Google, а для Яндекса сделать поддомены, то проверьте, закрыты ли региональные субдомены от индексации в Google в файле robots.txt, иначе подпапки начнут конкурировать с региональными сайтами. От ботов Яндекса аналогично нужно закрыть подпапки регионов.

Архитектура сайта

Поисковые боты анализируют страницы в рамках краулингового бюджета и в первую очередь посещают самые важные страницы — находящиеся на наименьшем расстоянии кликов от главной. Оцените структуру сайта и проверьте перелинковку на страницах: она должна помочь добиться индексации самых важных страниц в первую очередь, а навигация не должна препятствовать работе ботов.

Ссылки

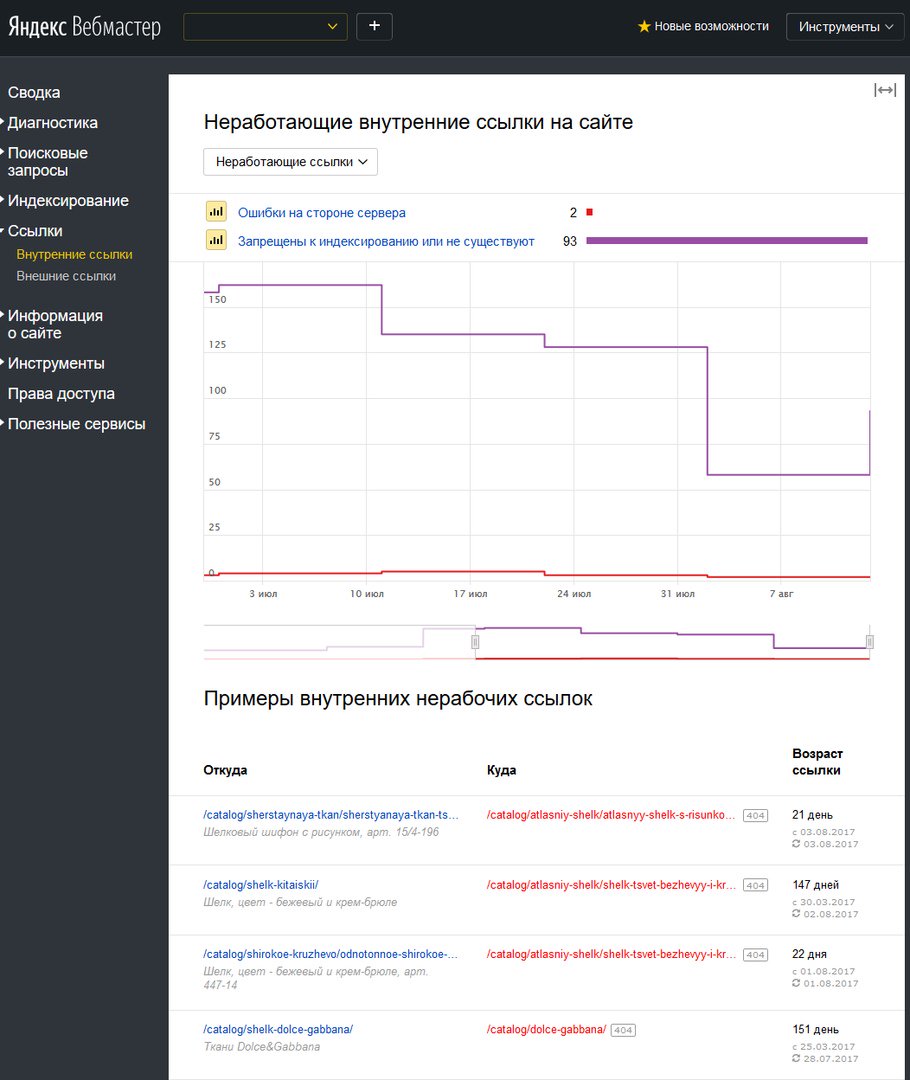

Оцените количество битых ссылок — ведущих на страницу 404. Внутренние битые ссылки участвуют во внутренней перелинковке и нарушают распределение ссылочного веса, перетягивая на себя часть авторитетности донора. Битые ссылки, ведущие на сторонние сайты, тоже пользы не приносят.

Если на сайте много битых ссылок, лучше исправить их, чтобы они не навредили.

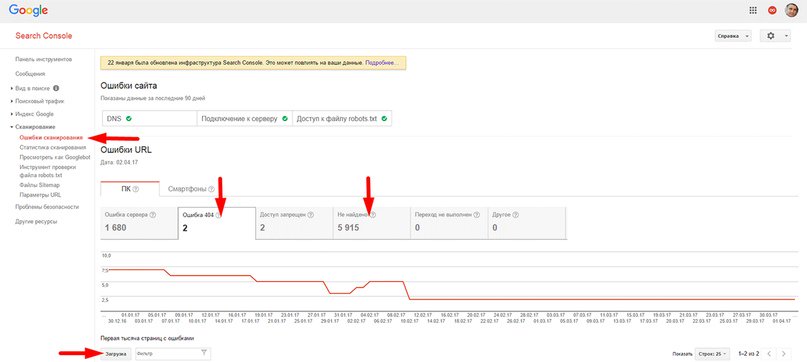

Найти битые ссылки для небольшого сайта можно вручную, но проще использовать инструменты Google и Яндекса.

Ошибки URL, скриншот с сайта devaka.ru

Страницы с ошибками консоль отображает в разделе «Сканирование» — «Ошибки сканирования».

Битые ссылки в Метрике, скриншот SEO блиц

Канонизация

Каноническую версию сайта устанавливают при помощи редиректа 301, она должна быть указана в GoogleWebmasterTools. Убедитесь, что канонический тег rel указывает на правильную страницу.

Проверьте, настроен ли 301 редирект для зеркал: при настройке зеркал для Яндекса нужно сделать 301 редирект со страниц неглавного зеркала на страницы основного, иначе контентные зеркала потеряют свою склейку и будут отдельными сайтами.

Техническая сторона

Стандартные инструменты Google Webmaster Tools могут помочь найти технические проблемы с сайтом, к примеру, определить ошибки 4хх и 5хх, найти недоступные страницы в карте сайта, найти проблему медленной загрузки и другие. Можно использовать и другие инструменты для проверки.

Редиректы

Проверьте, какой код ответа сервера отдают страницы с редиректами. Используйте 301 — этот редирект показывает, что показывает, что запрашиваемый документ был навсегда перенесен на другой URL, тогда бот склеит исходную и новую страницу.

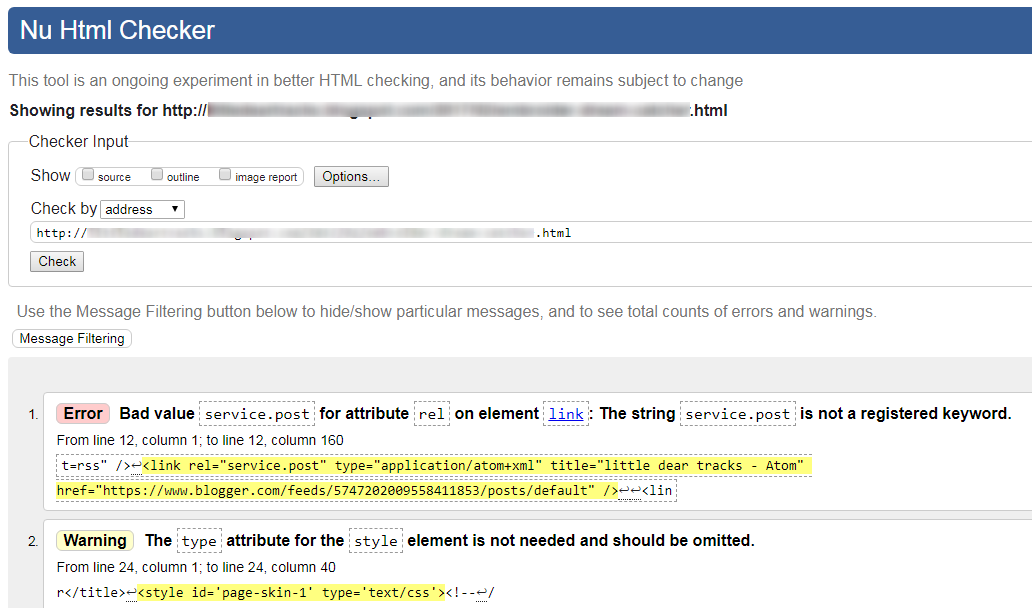

Валидация кода и элементы

Проверьте качество вашего кода и валидацию HTML и CSS — соответствие принятым нормам. Валидаторы кода подскажут, где есть ошибки, мешающие коду функционировать, как задумано, и выведут предупреждения с другими нарушениями правил верстки.

Интерфейс валидатора W3

Проверьте, используется ли Flash, и лучше избавьтесь от него для сохранения безопасности сайта и корректной работы на разных устройствах пользователей.

Скорость загрузки

Проверьте скорость загрузки ресурса на десктопной и мобильной версиях сайта. Если сайт медленно загружается, сайт потеряет часть пользователей, а бизнес — покупателей.

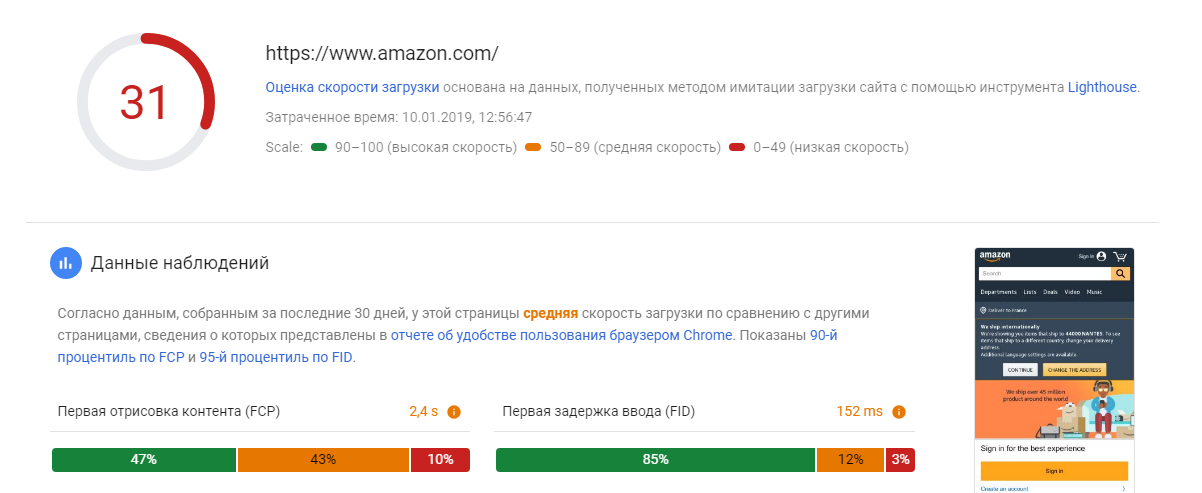

Для проверки можно использовать, к примеру, Google PageSpeed Insights, который дает подсказки по причинам торможения ресурса. Исправьте ошибки и доведите сайт хотя бы до зеленой области.

Проверка скорости сайта

Адреса ссылок

Проверьте «чистоту» URL: нет ли в списке индексации динамических URL с избыточными параметрами или ID сессиями.

Посмотрите, как формируются URL для страниц — они должны быть понятными для человека, желательно включающих ключевые запросы, сформированными из слов и не слишком длинными.

Заголовки

Проверьте уникальность Title и H1 заголовков на сайте, а также оптимизацию — используйте в теге основной ключ, желательно ближе к началу заголовка. Проверьте длину заголовка — если он длиннее 70 символов, может не влезть в поле заголовка в сниппете.

Если вы занимаетесь развитием своего бренда и его можно назвать узнаваемым у вашей аудитории, то используйте брендовый запрос в теге заголовка для подходящих страниц.

Заодно проверьте и оптимизацию контента: на страницах должно быть достаточно ключевых слов, чтобы текст не был заспамлен, но оставался релевантным ключевому запросу.

Если не хочется проверять руками

Если вам не хочется открывать десяток сервисов и проверять разные аспекты работы сайта, есть отдельные сервисы, которые работают в автоматическом режиме. Они проверяют сайт по этим и другим параметрам и дадут рекомендации в форме задач для исправления ошибок.

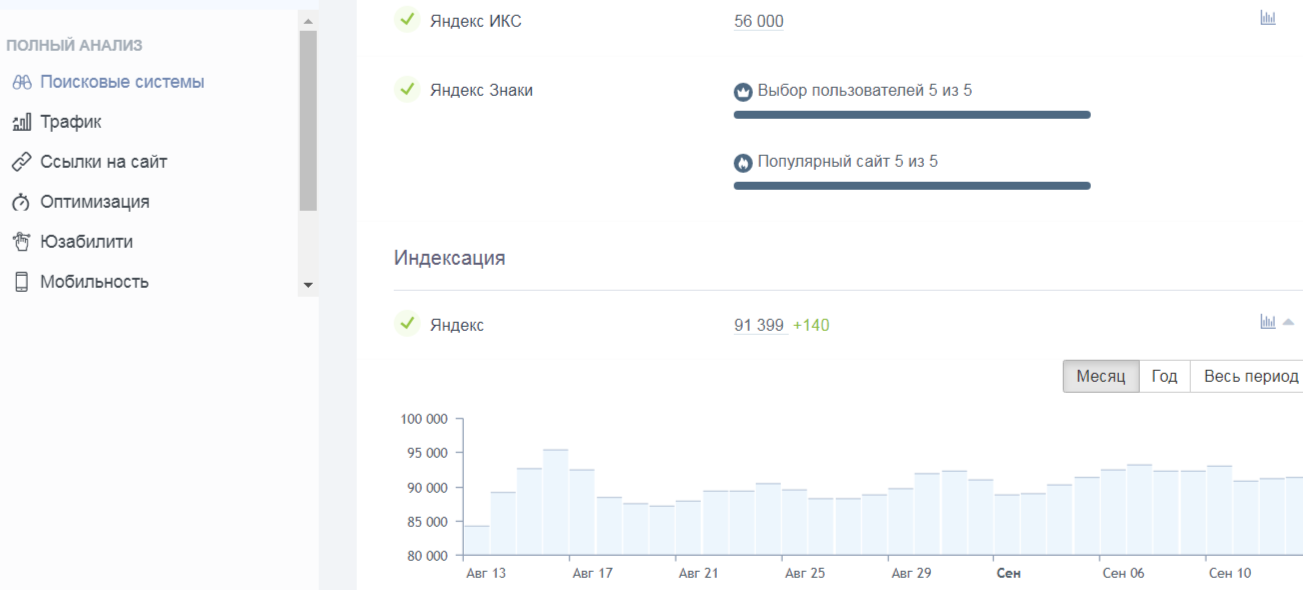

К примеру, сервис для автоматического аудита «Анализ сайта» проверяет главную страницу, сайт в целом и внутренние страницы ресурса. Он проверяет сайт по более 70 тестам, включая индексацию, изменения трафика, оптимизацию страниц, ссылки, технические параметры и другое.

Фрагмент интерфейса сервиса

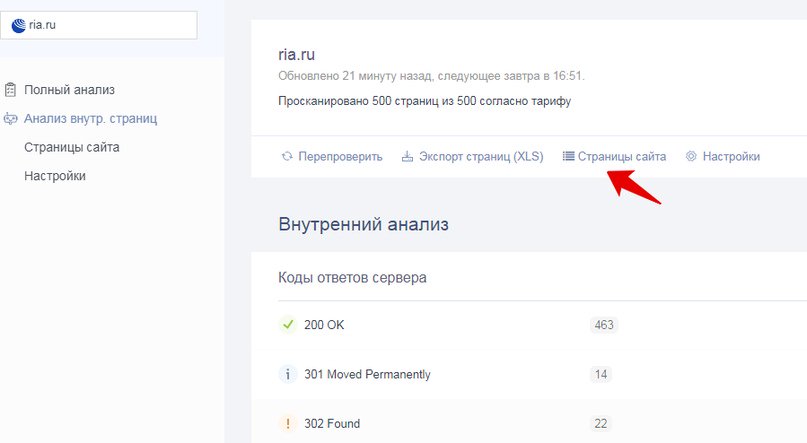

Проверка внутренних страниц покажет данные о кодах ответов сервера, мета-тегах, проведет анализ оптимизации контента на странице и технических данных со списком ошибок и пояснениями.

По кнопке «Страницы сайта» можно изучать список страниц, выставив интересующие фильтры, к примеру, с ошибками 404.

Фрагмент интерфейса сервиса

Бесплатный режим позволит провести поверхностный анализ, а проверять внутренние страницы, следить за динамикой показателей, формировать чек-листы и пользоваться другими возможностями можно в платных тарифах. Для функций платного «Анализа сайтов» есть недельный тестовый период.

Материал с templatemonster.com