Инструмент визуального поиска с AI-анимацией такой как Google Lens и Bing Visual Search, обещает новый способ поиска мир, но большинство людей все еще набирают в поле поиска, а не указывают на свою камеру на что-то. Мы привыкли вручную искать вещи за последние 25 лет или так, чтобы поисковые системы были у нас под рукой. Кроме того, не все объекты находятся прямо перед нами в то время, когда мы ищем информацию о них.

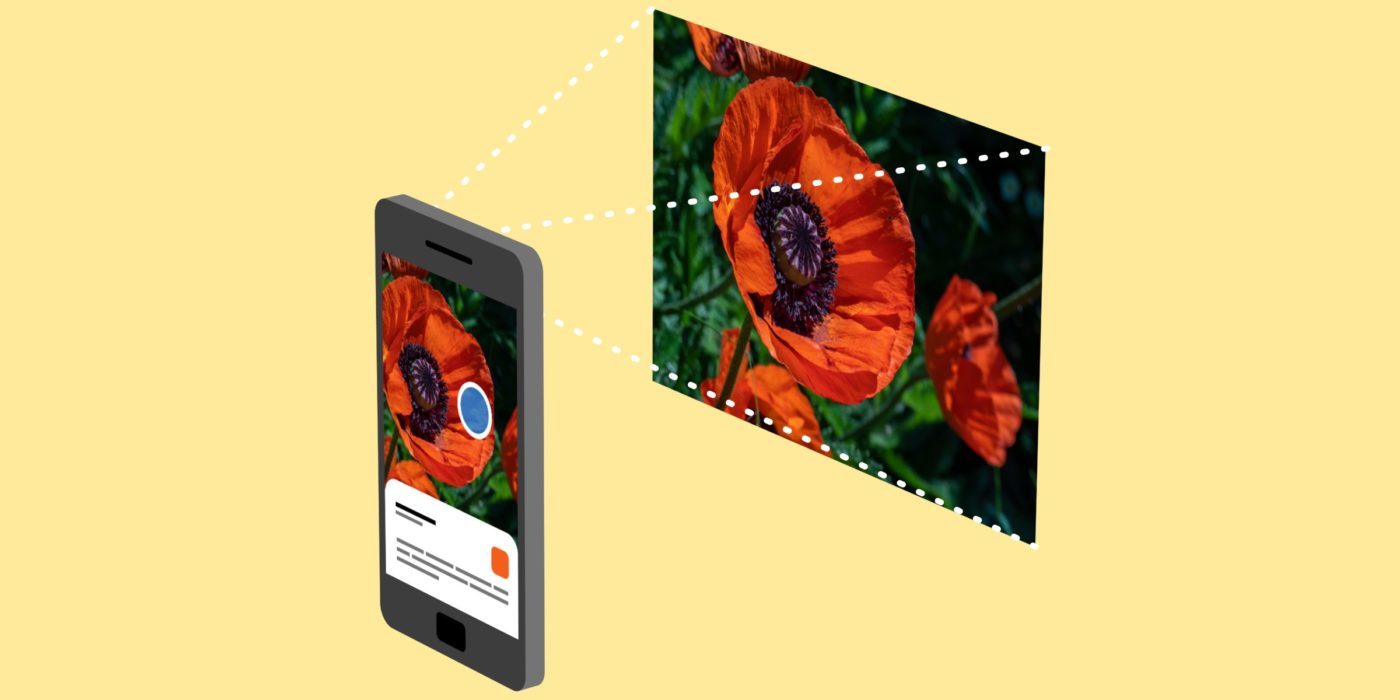

Одна из областей, где я нашел визуальный поиск полезной, находится вне, в естественном мире. Я часто хожу на походы, это форма отступления от постоянных цифровых взаимодействий, которые заставляют меня думать, что я живу своей «лучшей жизнью» в Интернете. В последнее время я привык использовать Google Lens, чтобы идентифицировать то, что я вижу на этом пути. Я указываю камеру своего телефона — в данном случае — телефон Android с объективом, встроенным в приложение Google Assistant, на дерево или цветок, которых я не узнаю. Приложение предлагает то, что может быть объектом, как современная версия образовательных плакатов, которые вы видите на ориентирах и в музеях.

Я понимаю, что ирония указывает на мой телефон на природе в тот момент, когда я используя природу в качестве передышки с моего телефона. Но смартфон действительно является идеальным инструментом в этом случае. Я не проверяю Twitter и не отправляю электронные письма. Я пытаюсь глубже проникнуть в опыт, который у меня уже есть.

Дело в том, что, находясь на улице, даже если вы думаете, что знаете, что это такое, вы действительно этого не делаете. Согласно исследованию из журнала «Устойчивое лесное хозяйство», в мире насчитывается более 60 000 видов деревьев. Есть 369 000 видов цветковых растений, из которых ежегодно открывается около 2000 новых видов сосудистых растений.

Я мог бы распознать цветущее дерево кизила на восточном побережье США (где я вырос) или гигантское дерево красного дерева в Северной Калифорнии (где я живу сейчас). Но в остальном «наши мозги имеют ограничения в качестве баз данных», — говорит Марлен Бехрманн, нейробиолог из Университета Карнеги-Меллона, который специализируется на познавательном уклоне визуального восприятия. «В базе данных« человеческий мозг »есть информация о деревьях как категории, но если у нас нет опыта или опыта, некоторые из этих вещей будут определены грубо».

Вводя кучу слов в поиск Google коробка не обязательно приносит вам конкретные результаты, даже если база данных обширна. «Блестящие зеленые растения с тремя листьями» поднимают более 51 миллиона результатов. Но объектив Google может идентифицировать растение как тихоокеанский ядовитый дуб в считанные секунды. Незадолго до того, как мы с другом начали поход в прошлом месяце, мы прошли кучу цветов, и она задумалась вслух о флоппи-белом цвете с крепистыми лепестками. Используя Google Lens, мы узнали, что это калифорнийский мак. (Позже, более глубокое погружение показало, что это был скорее матилийский мак.)

Я даже использовал Google Lens, чтобы спасти жизнь комнатного растения, оставшегося у друзей пары, когда они выехали из города. «Его зовут Эдвин», — сказали они. «Он едва нуждается в воде или солнечном свете. Слишком легко поддерживать жизнь», — сказали они.

. К тому времени, когда я попытался Google, это было почти мертво. Большая часть его листьев упала, и малейший ветерок мог вызвать гибель немногих оставшихся. Поиск «воскообразного зеленого дома с низким уровнем обслуживания» показал более миллиона результатов. К счастью, Google Lens идентифицировал его как своего рода филодендрон. Дальнейшие исследования сказали мне, что спасение Эдвина было бы драматичным: мне пришлось бы отрезать завод до пней и надеяться на лучшее. Эдвин теперь снова демонстрирует признаки жизни, хотя его новые листья настолько малы, что Google Lens распознает его только как цветочный горшок.

Объектив Google — не идеальное решение. Приложение, которое впервые было запущено в прошлом году и было обновлено этой весной, работает довольно хорошо «на лету» как часть Google Assistant или в собственной камере на телефоне Android, при условии, что у вас есть услуга сотовой связи. Использование Google Lens в Google Фото в iOS — единственный вариант для iPhone — становится вопросом, насколько хорошо замаскирована эта ящерица, когда вы ее видели, или резкость вашей фотографии. У пятислойного слинка есть отличительный синий хвост, но функция объектива в Google Фото на iOS все еще не могла сказать мне, что это было. Приложение сделало немедленно идентифицировать черепаху пустыни, которую я щелкнул в Национальном парке Джошуа Три несколько месяцев назад. (Мне не нужно, чтобы Google Lens рассказывал мне, что шумные позвонки свернуты у основания дерева, предупреждая меня остаться в аду, была гремучая змея.)

Я спросил Берманна, как наши мозги обрабатывают информацию, которая отличается от (или аналогичной) тем, что делает Объект Google. Что происходит, когда мы ясно осознаем, что что-то есть, но потом сражаемся с его родом; например, я знаю, что это дерево, но я не могу назвать его синим эвкалиптом. Берманн говорит, что нет простого ответа, потому что есть «несколько процессов, происходящих одновременно».

Некоторые из этих процессов «снизу вверх», а некоторые «сверху вниз», говорит Берманн. Внизу описывается информационный путь от сетчатки к зрительной коре; вы смотрите на что-то, как на дерево, а встроенная информация вызывает шаблон активации сетчатки. Затем эта информация перемещается в зрительные области вашего мозга, где ваш мозг начинает хруст данных и пытается понять визуальные сигналы.

Обработка сверху вниз больше зависит от контекстной информации или информации, которую наблюдатель имеет предыдущий опыт в этой среде. Это меньше связано с визуальной системой. «Как только они получают представление о том, на что они смотрят, эта нисходящая сессия ограничивает возможности« того, что это может быть », — говорит Берман. Она использует пример того, чтобы быть на кухне, а не снаружи, окруженной множеством неизвестных стимулов. Вы видите холодильник, поэтому вы знаете, что это кухня, и тогда ваш мозг может быстро распознать горшок на плите, один с носиком и ручкой, как чайник.

Объектив Google очень сильно опирается на дно . Но вместо использования вашей сетчатки она использует вашу смартфоновую камеру. Затем эта информация сопоставляется с массивной базой данных, чтобы понять, что происходит через объектив камеры. По сравнению с нашими мозгами Google хранит гораздо более обширную базу данных.

Конечно, Google Lens по-прежнему является продуктом Google, что означает, что в конечном итоге оно поддерживается рекламой. Как бы это ни было, если бы у меня была своя база данных в моем кармане, когда мой собственный мозг мне не помог, я знаю, что я помогаю подавать услуги Google при каждом поиске, который я запускаю, каждую фотографию, которую я привязываю. И искусственные интеллекты также склонны к предубеждениям, как и мы. Несознание цветка — это одно;

. Но визуальный поиск также заставил меня почувствовать, что я как-то более глубоко вовлечен в реальный мир в моменты, когда я испытываю это, вместо того, чтобы быть отстраненным от него бесконечная онлайн-болтовня. Это лучшая причина принести с собой ваш телефон при следующем походе.